2025-08-03

分享到

等领域的蓬勃发展,不仅是应用多样性的体现,更是AI计算模式从集中式云端向分布式边缘的根本性转变。

清晨,当你戴上AR眼镜开始规划通勤路线,此时你叫的无人出租车已在楼下等候;坐进车内,4K会议系统无缝接入云端协作平台,手里的手机可以实时翻译外语合同,并标注潜在风险条款,这样一幅未来生活图景的实现,背后的核心引擎正是智能算力。

在智能手机搭载4K视频与AR眼镜、出租车市场无人化的设定下,一个关键问题是:支撑这些场景的海量AI推理任务将由云端还是终端承担?芯片技术又该如何突破?

自2017年Transformer架构引发大语言模型(LLM)革命以来,人工智能的发展便紧密围绕“算力、数据、算法”三大核心要素展开。

在算法层面,Transformer架构凭借其强大的并行处理能力和高效的序列建模机制,已基本确立了主导地位,尽管仍有挑战者,但其核心地位短期内难以撼动。数据方面,除了传统的海量互联网数据,合成数据和3D时空数据正成为新的、日益重要的资源,为AI模型提供了更广阔的训练基础。而算力,作为驱动AI模型训练和推理的“发动机”,其迭代速度和发展方向,无论是云端集中式计算还是侧端分布式计算,都呈现出多元且快速的演进态势,预示着一场深刻的产业变革。

从应用上看,无人驾驶、无人机、手机、智能眼镜、AIPC等领域的蓬勃发展,不仅是应用多样性的体现,更是AI计算模式从集中式云端向分布式边缘的根本性转变。

这种转变的深层原因在于,新兴AI应用对低延迟、数据隐私和网络带宽效率需求迫切。边缘AI能够直接在设备上处理数据,显著降低了数据传输到云端再返回的延迟,这对于自动驾驶等需要实时决策的场景至关重要 。同时,本地处理数据也增强了用户隐私保护,减少了敏感信息在网络中传输的风险。此外,通过在边缘预处理和过滤,可以大幅减少需要传输到云端的数据量,从而节约宝贵的网络带宽资源 。这些应用层面的特性正在反向驱动算力架构的演进,使其更贴近数据源,形成一种新的计算范式。

未来五年,AI算力将是推动各行各业数字化转型和智能升级的关键基石。从支撑前沿大模型研发的超大规模云端数据中心,到赋能个人智能生活和工业自动化的高性能侧端设备,对高效、强大且普惠的算力需求将持续爆发式增长。这不仅关乎技术进步,更将重塑全球计算基础设施的格局。到2030年,全球AI基础设施投资预计将达到7万亿美元,其中近四分之三将流向数据中心。如此大规模的投资和增长,远超传统IT基础设施的升级速度,这表明AI正成为一种新的计算范式,需要从根本上重构现有的计算架构。这不再是现有系统的简单附加,而是对整个计算生态系统的基础性重塑。

边缘AI市场正经历一场“寒武纪”般的爆发,各种AI应用在设备端蓬勃发展,对算力提出了多样化、低功耗和实时性的新要求。

云端算力,特别是数据中心GPU市场,在未来五年仍将保持强劲增长。预计数据中心GPU市场将从2024年的873.2亿美元增长到2030年的2280.4亿美元,年复合增长率达13.7% 。云服务提供商(CSPs)将继续占据主导地位,这得益于其在AI基础设施上的巨额投资,以及提供“GPU即服务”的能力,使企业无需大量前期投资即可利用先进GPU技术进行大规模模型训练和部署 。

数据中心GPU市场增长主要由AI和机器学习的普及、高性能计算需求以及云计算服务的扩展驱动。其中,AI模型训练部分将显著增长,因为企业需要开发和完善大规模机器学习和AI模型,特别是生成式AI、计算机视觉和自然语言处理等深度神经网络应用,这需要专用的GPU集群。云端仍是大型基础模型训练的首选平台,因为其能够提供海量的计算资源、高速互联和数据存储能力,以应对模型参数量爆炸式增长带来的巨大计算需求。云服务提供商将继续是AI生态系统中不可或缺的基础设施伙伴,其在推动前沿AI研究和大规模模型开发方面的作用是无法替代的。

此外,边缘AI市场正经历一场“寒武纪”般的爆发,各种AI应用在设备端蓬勃发展,对算力提出了多样化、低功耗和实时性的新要求。

边缘AI市场预计将从2024年的493亿美元增长到2030年的819.9亿美元,复合年增长率8.84% 。其中,边缘AI加速器市场增长更为迅猛,预计将从2024年的76.8亿美元增长到2034年的942.7亿美元,年复合增长率高达28.5% 。这种高速增长得益于边缘AI在多个关键应用场景中的不可或缺性。比如,智能手机在2024年占据了边缘AI加速器市场超过34%的份额,成为推动边缘AI普及的关键力量 。

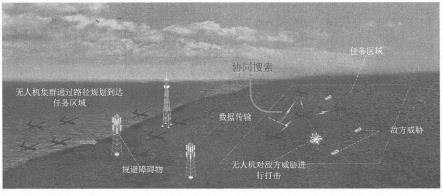

除了智能手机,智能眼镜与AR/VR同样对实时处理、低延迟和高能效的AI算力有极高要求;自动驾驶汽车需要实时处理来自毫米波雷达、激光雷达和摄像头的大量传感器数据,以进行路径规划、目标识别和避障,边缘AI芯片能够提供即时决策能力,避免了云端处理可能导致的延迟风险;无人机在公共基础设施检查等领域,也需要低功耗的边缘AI芯片进行4K视频的实时推理处理,PG电子游戏下载以实现远距离目标检测……

值得注意的是,边缘AI市场(8.84% CAGR)与边缘AI加速器市场(28.5% CAGR)之间存在显著的增长率差异。这种差异暗示了在更广泛的边缘AI生态系统中,硬件组件(特别是专用加速芯片)的增长速度远超其他部分,表明硬件能力是当前边缘AI发展的关键瓶颈和主要驱动力。

这种现象的出现,主要是因为大型AI模型(特别是LLM)的复杂性日益增加,需要在资源受限的边缘设备上进行高效推理,这使得对专门优化的硬件需求激增。此外,随着AI应用从云端向边缘迁移,对低功耗、高效率芯片的需求也随之增长,以满足电池供电设备和实时应用的要求。因此,芯片制造商正大力投资研发,以提供满足这些特定需求的边缘AI加速器,从而推动了这一细分市场的快速扩张。

根据最新预测,AI芯片市场规模预计将从2025年的1061.5亿美元(AI推理市场)或863.7亿美元(AI芯片组市场)增长到2030年的2549.8亿美元至4530亿美元不等,年复合增长率(CAGR)在14%到26.66%之间。AI计算机市场更是预计从2024年的510.997亿美元飙升至2030年的2816.727亿美元,复合年增长率高达34.4% 。整体AI市场规模预计到2030年将达到12364.7亿美元,复合年增长率32.9%。

“AI芯片”“AI计算机”以及“整体AI市场”的复合年增长率存在差异。这种差异揭示了AI价值链的演变。芯片是硬件基础,但其价值实现需要通过集成到完整的系统(如AI PC、AI服务器)中或通过提供软件服务获取。高增长率的领域(AI计算机、整体AI市场)包含了更多的软件、系统集成和应用层面的价值。这表明,市场正在从单纯的硬件销售转向更强调全栈解决方案和生态系统服务。

数据中心GPU市场由人工智能和机器学习的广泛采用、对高性能计算(HPC)需求的日益增长以及云计算服务的持续扩展所驱动。这些因素共同推动了对GPU的需求,以支持深度学习、大型语言模型和数据分析等先进应用。

英伟达凭借其在GPU技术和AI生态系统方面的深厚积累,稳固地占据着云端AI算力的王者地位。其GPU广泛应用于微软、亚马逊、谷歌和甲骨文等主要云服务提供商的AI基础设施中 。

边缘AI芯片的设计核心则在于如何在有限的功耗和尺寸下,实现高性能的AI计算。边缘AI算力的技术方向非常突出,比如模型微型化,3B参数级MoE(混合专家)模型成为主流,在保留95%精度的同时,算力需求降至1/10;通过量化(Quantization)和稀疏化 (Sparsity)减少模型的内存占用和计算量,有效平衡速度、内存效率和计算精度。

此外,需要注意的是,随着AI模型规模的指数级增长和计算密度的不断提高,数据中心正面临前所未有的能耗和散热挑战。因此,基础设施创新,特别是能效和互联技术,成为未来五年云端算力发展的关键。传统风冷系统已难以满足现代AI硬件产生的巨大热量。液冷和浸没式冷却技术正从利基市场走向主流,成为数据中心能效提升的必然选择。

直接液冷 (Direct Liquid Cooling,简称DLC)是通过管道和冷板将冷却液直接循环到CPU和GPU等发热组件,实现源头散热,防止过热和性能节流。例如,联想的Neptune水冷技术通过直接水冷CPU、GPU和NVIDIA NVSwitch(英伟达一款高速互联的芯片),实现了高达40%的功耗降低和3.5倍的热效率提升,并将数据中心PUE(Power Usage Effectiveness)降低到1.1。

浸没式冷却(Immersion Cooling)则是将整个服务器浸没在非导电液体中,这种方法比风冷更能有效地散热,使AI芯片在持续高负载下保持最佳性能。浸没式冷却能够实现更高的计算密度,减少空间需求,并进一步提高能效。

未来五年,AI算力将不再是单一维度的竞争,而是云端与侧端协同发展、硬件与软件深度融合、能效与性能并重的一场深刻变革。

混合AI计算模型将AI工作负载智能地分布在云端和边缘设备之间,也就是业界常说的“云边协同”。

其优势主要包括可以降低延迟,边缘设备处理时间敏感的数据,例如自动驾驶汽车的实时决策,避免了数据传输到云端带来的延迟;敏感数据可以在本地处理,减少了向外部服务器传输的风险,符合GDPR等数据隐私法规的要求;边缘AI通过本地处理数据,最大程度地减少了互联网数据传输量,从而节省了网络带宽和云数据传输及存储成本;即使在网络连接不稳定或受限的区域,边缘设备也能独立运行,提供服务连续性;混合AI模型允许企业根据工作负载波动动态调整资源分配,将更复杂的任务卸载到云端,同时在边缘处理即时需求,优化了成本效益。

与此同时,云边协同的挑战也同样存在,比如跨云端和边缘环境部署和管理AI解决方案需要复杂的协调和集成;边缘设备的计算和存储资源通常有限,难以运行大型复杂的AI模型;尽管边缘处理有助于隐私,但分布式环境下的数据安全和治理仍是挑战;要确保云端训练的模型能够高效地在异构边缘设备上运行并保持一致性,以及模型的持续更新和维护,都需要精密的策略。

而云边协同的技术创新也值得关注,比如在数据隐私和效率上,为了克服边缘设备的资源限制并保障数据隐私,模型分区(Model Partitioning)和联邦学习(Federated Learning,简称FL)正成为关键技术。

模型分区将大型AI模型(特别是LLM)分割成多个部分,一部分部署在资源受限的边缘设备上(客户端侧模型),另一部分部署在云端服务器上(服务器侧模型)。客户端侧模型处理原始本地数据,并将中间激活值发送给服务器,服务器则处理剩余的模型部分并梯度返回。这种方法减轻了边缘设备的计算负担,同时减少了数据传输量。例如,针对视觉Transformer模型,自适应模型分区机制可以根据设备资源调整模型复杂度,减少层间通信,实现高达32.6%的延迟降低和16.6%的能耗节省 。

联邦学习则是一种去中心化的机器学习范式,允许在多个边缘设备上共同训练一个共享模型,而无需将原始敏感数据集中到中央服务器。这极大地提升了数据隐私保护,降低了通信开销,并支持个性化模型。在物联网(IoT)生态系统中,联邦学习已成为实现边缘AI的关键技术,特别适用于医疗保健、智能制造和网络安全等涉及敏感数据的应用。通过结合联邦学习和边缘AI,可以实现模型准确性10%~15%的提升,并降低通信成本25%。

未来五年,AI算力将不再是单一维度的竞争,而是云端与侧端协同发展、硬件与软件深度融合、能效与性能并重的一场深刻变革。